2025年6月21日

【2025年最新版】ChatGPTのモデルを徹底解説|用途・価格・使い分けガイド

ChatGPTのGPT-4.1・GPT-4o・o3シリーズなど、OpenAIが提供する各モデルの違いと用途、価格をわかりやすく解説。情シス・開発者向けのモデル選定ガイド付き。

2025年8月8日(日本時間)にGPT-5が発表されました。GPT-5については以下の記事をご覧ください。

生成AIの進化は目覚ましく、OpenAIをはじめとした企業から次々と新しいモデルが登場しています。しかし、どのモデルを使えば良いか分からない…そんな声を多く聞きます。

日々様々な会社からリリースされるモデルの特徴と使い分けを理解するには、それだけで膨大な時間を要します。

またモデルによってはChatGPTのアプリから使用できるもの、開発者向けにAPIでしか提供していないものなどがあります。

本記事では OpenAI Platform のモデル説明を参考にしながら、OpenAI社が提供する様々なChatGPTのモデルについて解説し、モデルの選び方やコストパフォーマンスなどについて解説していきます。

用途別に分類したChatGPTモデルのカテゴリ

各社が発表するモデルは、それぞれ用途に合わせて分類できます。

大まかなカテゴリは下記の通りです。

- 汎用モデル

- 高速・低コストモデル

- 推論モデル(reasoningモデル)

- マルチモーダルモデル

汎用モデル:バランス重視で万能

ほとんどの用途で最適と言って良いモデルがこの汎用性のカテゴリに該当するモデルです。

OpenAI社の対応モデル

- GPT-4.1

- GPT-4.1 mini

- GPT-4o

2025年6月時点で、ChatGPTのアプリケーション上ではデフォルトがGPT-4oになっていることからも、汎用的にかつコストをかけ過ぎずに多くのユースケースで高いパフォーマンスを発揮できるモデルのひとつです。

社内のヘルプデスク業務を担当させるのであれば、基本的にはこの汎用モデルが推奨です。

高速・低コストモデル:主に開発者向けに費用を低減

高速に動作することと、費用を安く抑えることに特化したモデルです。

OpenAI社の対応モデル

- GPT-4.1 nano

- GPT-4o mini

ChatGPTなどのアプリケーション上から使用する上では、GPT-4oでも十分高速に動作する上に、月額費用が固定であるためユーザー側が意識して使用するシーンは限定的かも知れません。

一方で、既存のアプリケーションに生成AIの機能を組み込む上では、日々の業務の中で膨大な量のデータを処理する必要があり、またその処理が複数ステップに渡る場合などでは、高速かつ低コストで実行できるこれらのモデルは重宝されます。

推論モデル:複雑な論理的思考が得意

「コード生成」「データ分析」「設計支援」など、高度な論理的思考を必要とするタスクに特化したモデルは推論モデルと呼ばれます。

OpenAI社の対応モデル

- o3

- o3-pro

- o4-mini

論理的な思考では、複数ステップの思考や仮説検証を挟むため、ステップ毎の論理的な妥当性がより求められます。このときに複数ステップの思考をした上で処理を行う推論モデルが最適な用途といえます。

マルチモーダルモデル:音声・画像・動画を扱うときに

テキスト・画像・音声・動画など、様々なデータの種類を取り扱えるのが、マルチモーダルモデルの最大の強みです。

OpenAI社の対応モデル

- GPT-4o

- GPT-4o mini

- GPT Image 1

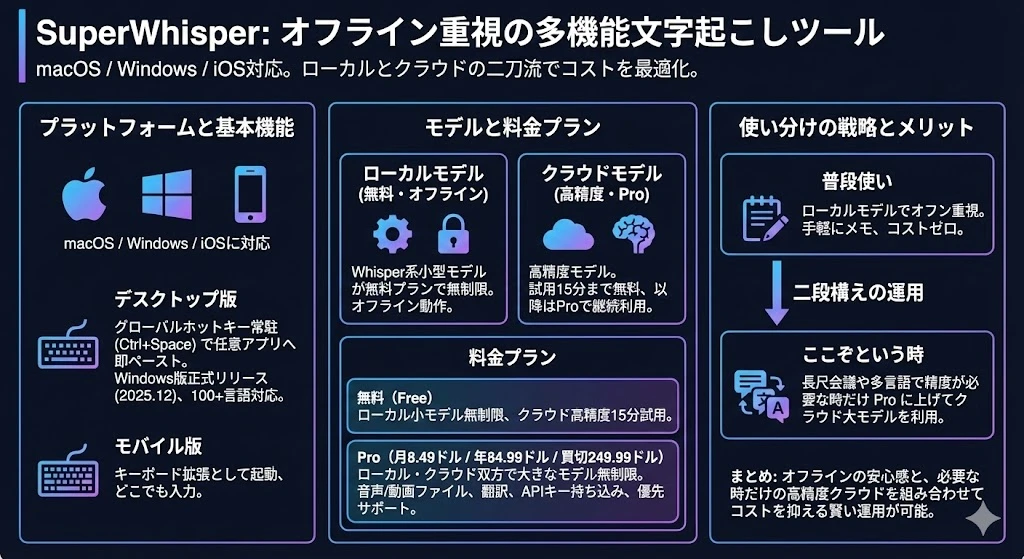

- Whisper

- Sora

GPT-4oは音声の入出力をサポートし、GPT Image 1は高品質な画像生成、Soraは動画生成が可能です。Whisperは軽量な音声文字起こしモデルとして、アプリケーションや開発者向けの両方で広く使われています。

OpenAI が提供する主要なモデル一覧

OpenAI社が提供する主要なモデルの一覧です。※価格は 料金 | OpenAI より参照。

モデル名 | コンテキストウィンドウ | 価格(1Mトークンあたり) | カテゴリ | 詳細 |

|---|---|---|---|---|

GPT-4.1 | 1,047,576 | 入力$2.00 / 出力$8.00 | 汎用 | 汎用性の高いフラッグシップモデル |

GPT-4.1 mini | 1,047,576 | 入力$0.40 / 出力$1.60 | 汎用 | 汎用性と速度・コストを両立 |

GPT-4.1 nano | 1,047,576 | 入力$0.10 / 出力$0.40 | 高速・低コスト | GPT-4.1 miniより高速・低コスト |

GPT-4o | 128,000 | 入力$2.5 / 出力$10 | 汎用 / マルチモーダル | テキストと画像に対応した汎用モデル |

GPT-4o mini | 128,000 | 入力$0.15 / 出力$0.60 | 高速・低コスト / マルチモーダル | 速度・コストとマルチモーダルを両立 |

o3 | 200,000 | 入力$2.00 / 出力$8.00 | 推論 | バランスの取れた強力な推論モデル |

o3-pro | 200,000 | 入力$20 / 出力$80 | 推論 | 最も強力な推論モデル |

o3-mini | 200,000 | 入力$1.10 / 出力$4.40 | 推論 / 高速・低コスト | 速度と費用に優れた推論モデル |

o4-mini | 200,000 | 入力$1.10 / 出力$4.40 | 推論 / 高速・低コスト | 高速・低コストな推論モデル |

GPT-4.1

GPT-4.1は、OpenAIのフラッグシップ的なマルチモーダル大規模言語モデル(LLM)です。

汎用性が高くほとんどの用途で活用でき、テキストや画像を入力として受け取ることができます。

またOpenAIが提供するモデルの中では最大のコンテキストウィンドウ(約104万トークン)を入力できるという強みもあります。

- 入力: テキスト、画像

- 出力: テキスト

- コンテキストウィンドウ:1,047,576 トークン

- 知識のカットオフ:2024年6月1日

- 価格(100万トークンあたり)

- 入力:$2.00

- 出力:$8.00

GPT-4.1 mini

GPT-4.1を高速かつ低コストにしたモデルです。

また性能も優れているため、多くの用途で汎用的に使用できるモデルです。

- 入力:テキスト、画像

- 出力:テキスト

- コンテキストウィンドウ:1,047,576 トークン

- 知識のカットオフ:2024年6月1日

- 価格(100万トークンあたり)

- 入力:$0.40

- 出力:$1.60

GPT-4.1 nano

GPT-4.1をminiよりもさらに高速かつ低コストにしたモデルです。

miniよりも高速な処理や、大規模なデータを処理する必要がある場面で使用できます。

- 入力:テキスト、画像

- 出力:テキスト

- コンテキストウィンドウ:1,047,576 トークン

- 知識のカットオフ:2024年6月1日

- 価格(100万トークンあたり)

- 入力:$0.10

- 出力:$0.40

GPT-4o

マルチモーダル機能に特化した汎用的なモデルです。GPT-4.1と並び、汎用モデルとして様々な業務で活用しやすいという特徴があります。

- 入力:テキスト、画像

- 出力:テキスト

- コンテキストウィンドウ:128,000 トークン

- 知識のカットオフ:2023年10月1日

- 価格(100万トークンあたり)

- 入力:$2.5

- 出力:$10

GPT-4o mini

マルチモーダルかつ速度とコストに優れたモデルです。現時点では GPT-4.1 mini と GPT-4.1 nano が代わりに使える、精度面や知識のカットオフの観点でやや使用頻度は下がっていますが、様々な用途で一定のパフォーマンスが期待できるモデルです。

- 入力:テキスト、画像

- 出力:テキスト

- コンテキストウィンドウ:128,000 トークン

- 知識のカットオフ:2023年10月1日

- 価格(100万トークンあたり)

- 入力:$0.15

- 出力:$0.60

o3

o3は現在提供されている中で非常に高いパフォーマンスを誇るフラッグシップ的なモデルです。さらに長い推論には o3-pro が利用できますが、 o3-pro は非常に推論時間も長くなるため、費用面さえパスできれば推奨のモデルです。

- 入力:テキスト、画像

- 出力:テキスト

- コンテキストウィンドウ:200,000 トークン

- 知識のカットオフ:2024年6月1日

- 価格(100万トークンあたり)

- 入力:$2.00

- 出力:$8.00

o3-pro

o3-pro は回答前に事前に複雑な思考を経ることで、最も計算リソースを使用する代わりに、最も高い推論能力を有するモデルです。

ただしChatGPTのアプリ上では、処理に数分から数十分ほどの時間がかかることもあり、非常に複雑な推論を要求するタスクに特化したモデルといえます。

- 入力:テキスト、画像

- 出力:テキスト

- コンテキストウィンドウ:200,000 トークン

- 知識のカットオフ:2024年6月1日

- 価格(100万トークンあたり)

- 入力:$20.00

- 出力:$80.00

o3-mini

o3-mini は、費用を抑えた o3 の代替品として提供されています。

o3シリーズの中では、このモデルだけ若干カットオフの時期が早いこと、そして画像を入力として扱えない点には注意が必要です。

- 入力:テキスト

- 出力:テキスト

- コンテキストウィンドウ:200,000 トークン

- 知識のカットオフ:2023年10月1日

- 価格(100万トークンあたり)

- 入力:$1.10

- 出力:$4.40

o4-mini

o3-mini と同じ価格で画像を扱え、また知識のカットオフが o3-mini よりも半年以上後である程度最新の知識を扱うことができるのが特徴のモデルです。

- 入力:テキスト、画像

- 出力:テキスト

- コンテキストウィンドウ:200,000 トークン

- 知識のカットオフ:2024年6月1日

- 価格(100万トークンあたり)

- 入力:$1.10

- 出力:$4.40

OpenAIモデルの選び方ガイド

ここまででモデルの主な用途に基づくカテゴリ、そして実際にOpenAIから提供される各モデルの詳細を見てきました。

本章ではそれらの情報を踏まえて、どんな用途にどんなモデルを使えば良いのかを記載します。また開発者向けかユーザー向けかなど、踏み込んだ使い分けについても解説します。

迷ったときは汎用モデル

ほとんどの業務で適したモデルが汎用モデルです。

ChatGPTアプリのユーザーなら画面上から GPT-4o か GPT-4.1 を使い、費用をある程度気にする必要がある開発者であれば必要に応じて GPT-4.1 mini, GPT-4.1 nano, GTP-4o miniなどを選択肢に入れれば良いでしょう。

汎用モデルが適したビジネス上のユースケースには下記のようなものが考えられます。

- FAQの自動応答

- メール返信の文章作成

- マニュアル・議事録の要約

- ブログ記事の下書き作成やレビュー

- プレゼン資料の構成提案

- 多言語翻訳

- 業務日報や報告書のチェック

- プログラムやHTML / CSSの軽微な修正

論理的な深い推論が必要なときの推論モデル

コーディング、数学など、論理的な深い思考が必要なときには推論モデルを使用します。

ChatGPTのアプリ上であれば、基本的には o3 を使用し、数十分かかっても良いようなタスクがあれば o3-pro を使用する選択肢もあります。

開発者であればまずは o3-mini か o4-mini を試し、費用対効果に注意しながら、 o3 などのより複雑な推論ができるモデルを使用するのが良いでしょう。

推論モデルが適したビジネス上のユースケースには下記のようなものが考えられます。

- SQLやPythonでの集計処理のスクリプト作成

- 資料の多面的なレビュー

- 市場分析

- 市況や競合のデータに基づく意思決定

- 複雑なアルゴリズムの考案

- セキュリティ評価

- インフラ構成のレビュー

- ソースコードのバグの原因分析

- 仕様書の網羅性や抜け漏れのチェック

テキスト埋め込みモデル

テキストをベクトルに変換するためのモデルが埋め込みモデルとして提供されています。

ユーザーが直接意識することはありませんが、開発者がRAGや機械学習やレコメンドを構築するなどの用途で、主に利用されています。

text-embedding-3-small

text-embedding-3-small は 2024年1月に発表された 小規模なテキスト埋め込みモデルで、高速な動作と平均的なパフォーマンスを誇ります。

OpenAIでそれ以前に提供されていた"text-embedding-ada-002"と比較して、大幅にパフォーマンスが向上し、さらに費用も1/5となっている優れたモデルです。

- 費用:100万トークンあたり0.02ドル

- 次元数:最大1536次元

text-embedding-3-large

text-embedding-3-large は small と同時に発表されたテキスト埋め込みモデルで、現在 OpenAI 社が提供するモデルの中で、最も優れたパフォーマンスを誇ります。

- 費用:100万トークンあたり0.13ドル

- 次元数:最大3072次元

text-embedding-ada-002

text-embedding-ada-002 は前述の2つのモデルが発表される前から提供されていたテキスト埋め込みモデルです。

現時点では費用・パフォーマンスの両面で非推奨とはされていますが、機能自体はまだ提供されています。

ChatGPTでヘルプデスクを自動化する

ChatGPT の GPTs を活用し、ヘルプデスクを効率化する方法を記載しています。

今すぐ生成AIチャットボットで社内問い合わせ対応を自動化しませんか?

ENSOUチャットボットは、AIエージェントにより問い合わせ削減に繋げることができるAIエージェントサービスです。

社内の問い合わせ対応にお困りの方は、お気軽にご連絡ください。

サービス資料をダウンロードする👇

導入相談をする(最短15分のオンライン相談)👇