2026年1月6日

Codex CLIでLM StudioのローカルLLMを使う

Codex CLIを、LM Studioで動かすローカルLLM(OpenAI互換のローカルAPI)につないで、ローカル環境でコーディングエージェントとして使う手順をまとめます。

はじめに

本記事では、LM Studio でローカルLLMを動かし、Codex CLIでそのLLMに接続し、ローカルでコーディングエージェントを動かす方法について記載します。

結論から言うと、LM Studioで「OpenAI互換API」を起動し、Codex CLIの設定でそのURLを参照するようにすれば、Codex CLIをローカルLLMにつないでコーディングエージェントとして動かせます。

このLM Studioの活用によって、コーディングエージェントをローカルで動かすことができ、セキュリティ的に一般的なコーディングエージェントの利用が難しいケースでも、セキュアに利用できる可能性が広がります。一方で「ローカルLLMで動かす=完全にオフライン」ではありません。たとえば初回のモデル取得、拡張機能の更新、外部依存のインストールなどはネットワークが関わることがあります。運用要件(社内ポリシーやログの扱い)に合わせて、どこまでをローカルに閉じるかは切り分けて考えるのが安全です。

また、Codexには使用量に制限があるため、このローカルLLMで動かす方法により、その制限を回避することが可能です。

今回の記事はOpenAIのCodexに関する公式ドキュメントに基づいて、記載しています。

Codex CLI とは?

Codex CLIは、ターミナルからリポジトリを読み込み、ファイル編集やコマンド実行を支援するエージェントです。設定は ~/.codex/config.toml で管理でき、モデルの指定や接続先を切り替えられます。

Codex については以下の記事でまとめていますので、よろしければこちらの記事もご覧ください。

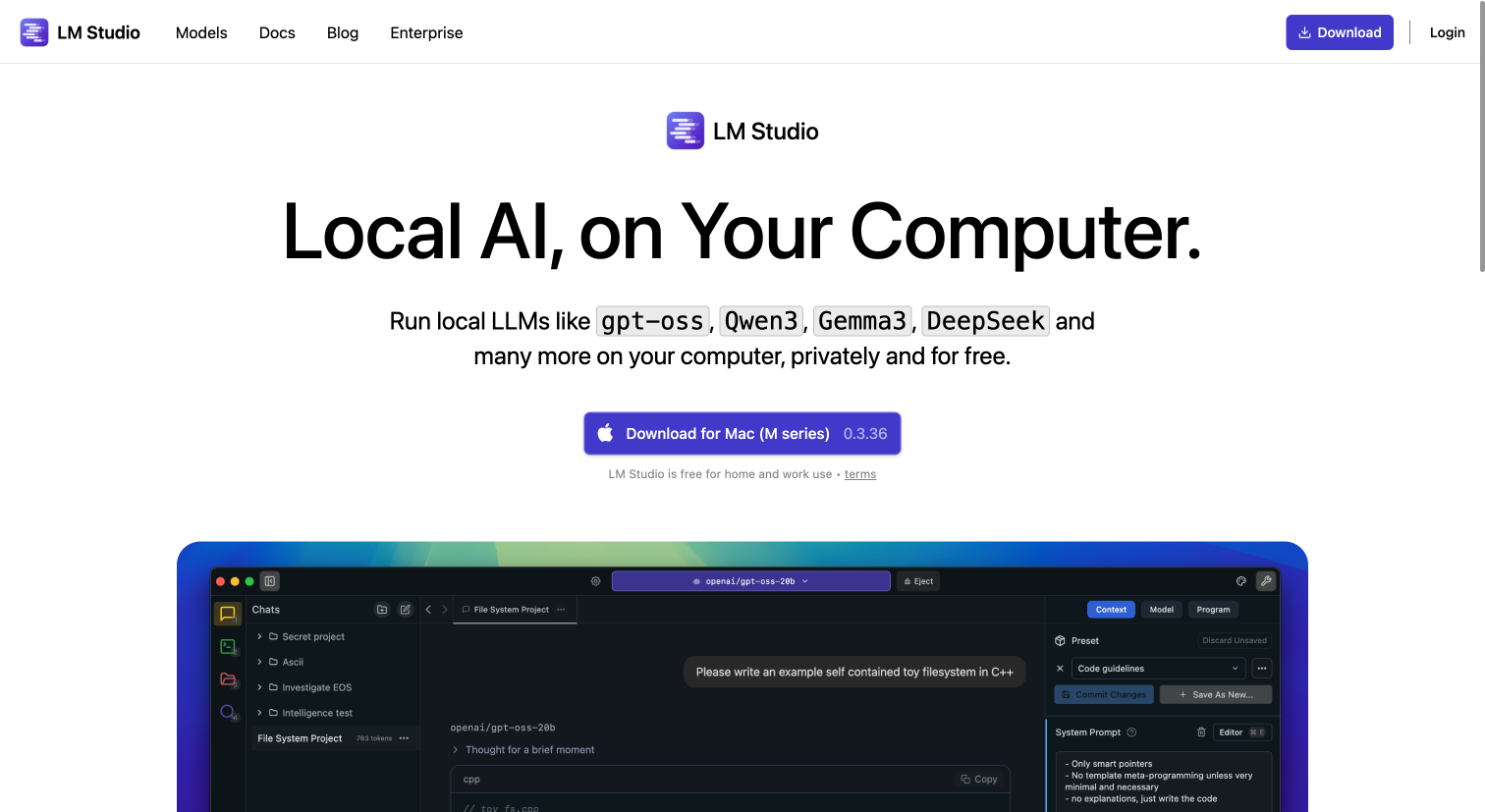

LM Studio とは?

LM Studioは、ローカルマシン上でLLMを動かし、外部ツールから呼び出せるようにするための環境です。特に本記事では、LM Studioが提供する「OpenAI互換エンドポイント(/v1)」を使い、Codex CLIから localhost にHTTPでアクセスする形を扱います。

LM Studioについては、以下の記事で説明していますので、こちらの記事もよろしければご覧ください。

LM Studioのセットアップ

ここでは、LM Studioの「ダウンロード → インストール → モデルのダウンロード → ローカルサーバ起動」までを行い、Codex CLIから呼べる準備をします。

1) LM Studioをダウンロードしてインストールする

LM Studioは公式サイトから最新版をダウンロードしてインストールできます。まずはLM Studioをインストールし、起動してください。

インストールできたら、LM Studioは Power User モードで起動しておくと、後続の設定(開発者向けの操作)が進めやすくなります

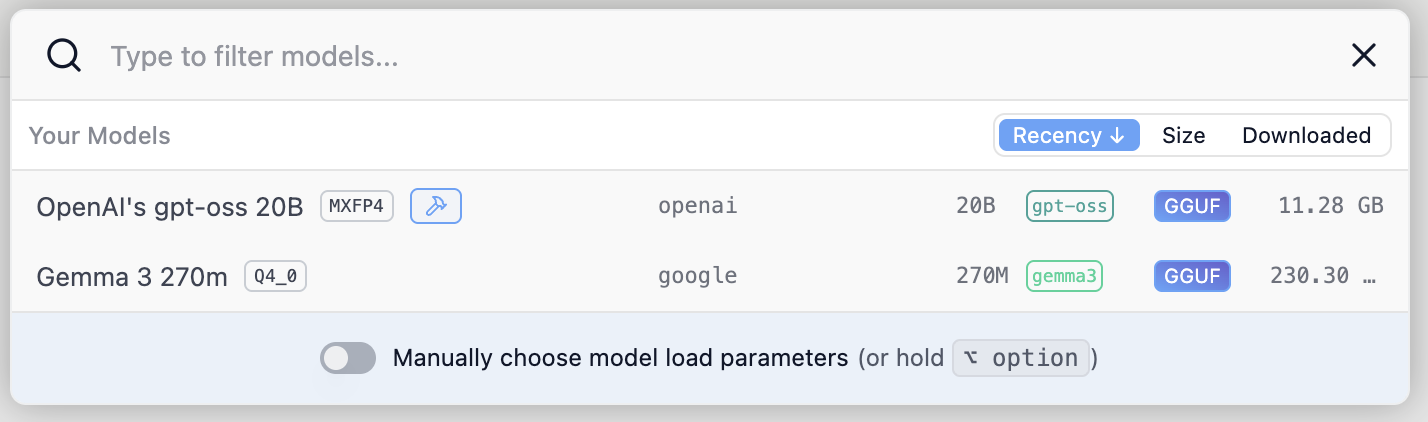

2) モデルをダウンロードして動作確認する

LM Studioの探索(Explore)タブなどからモデル名を検索し、任意のモデルをダウンロードします。今回は gpt-oss-20b を利用します。

ダウンロードが完了したら、Use in New Chat などからチャットを開き、まずはLM Studio単体で応答が返ることを確認します。

3) コンテキスト長を調整する

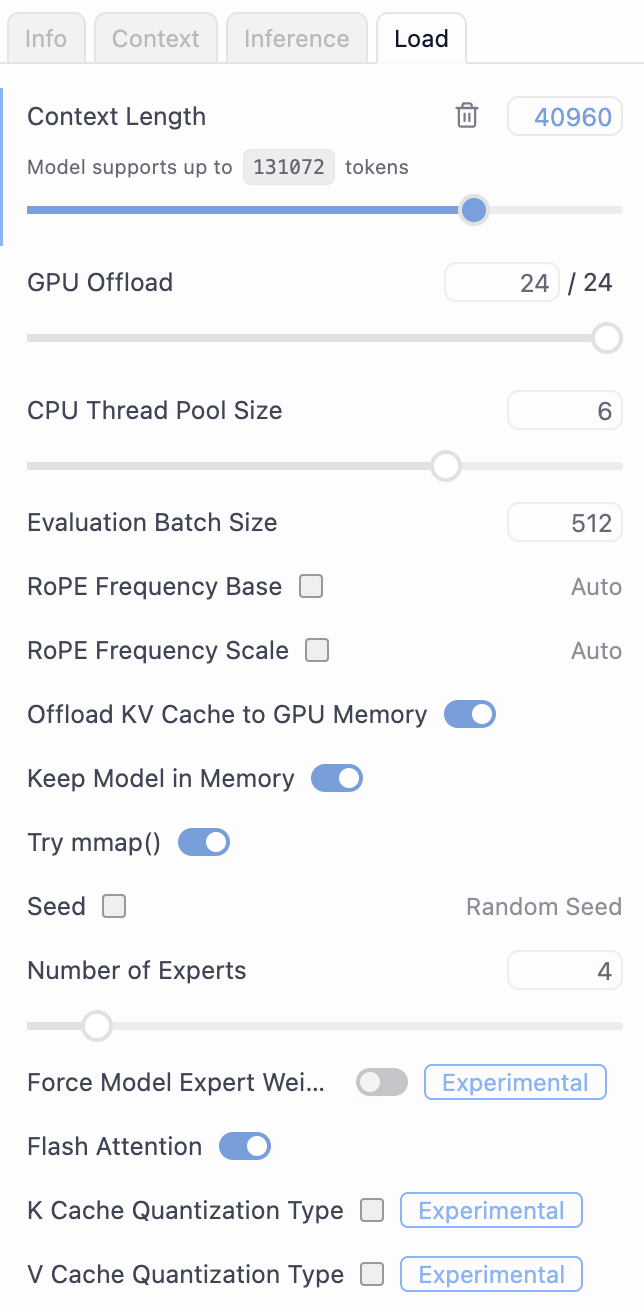

Developer画面において、画面右側にある Context Length が gpt-oss-20b のデフォルトでは4096になっており、これを 40960 などに変更します。

これは、Codexのシステムプロンプトが4096以上の長さがあり、この後エラーになる可能性を避けるためです。

この設定が完了すれば、サイドバーの下部にある「Reload to apply changes」ボタンをクリックします。

これで LM Studio 側の準備は完了です。

Codex CLIの設定

次はCodex CLI側の接続先を設定します。

~/.codex/config.toml を開いて、以下を追記します。

profile = "gpt-oss-20b"

[model_providers.lmstudio]

name = "LMStudio"

base_url = "http://127.0.0.1:1234/v1"

[profiles.gpt-oss-20b]

model = "openai/gpt-oss-20b"

model_provider = "lmstudio"もしLM Studio側のポートを 1234 以外にしている場合は、base_url のポート番号を合わせて変更してください。

LM Studio + Codex を実際に試してみる

ここまでできたら、いよいよCodex CLIを起動してみます。

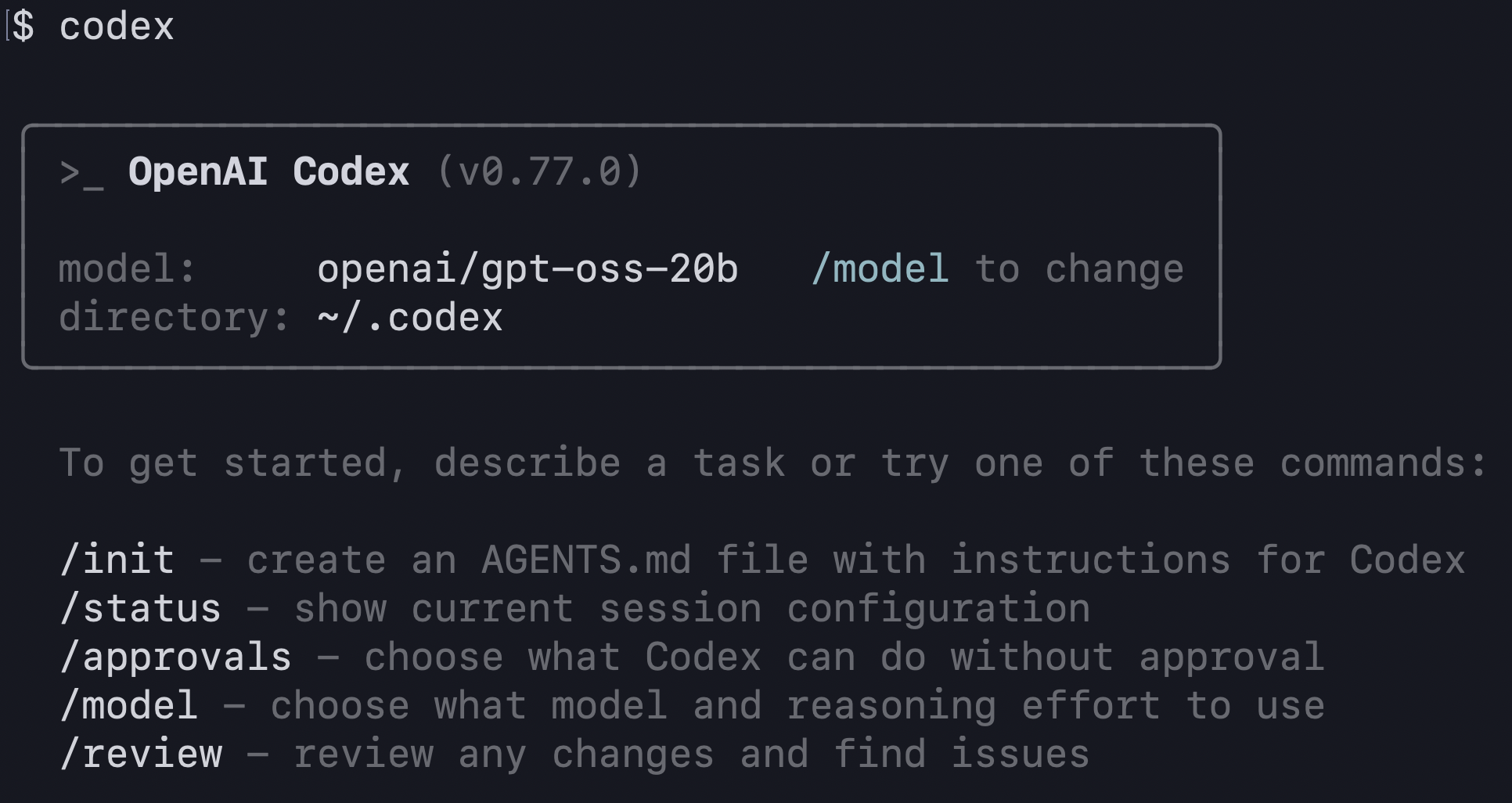

$ codex上記のコマンドをうち、以下のような画面が表示されれば、LM Studio のローカルLLMでCodexを起動できています。

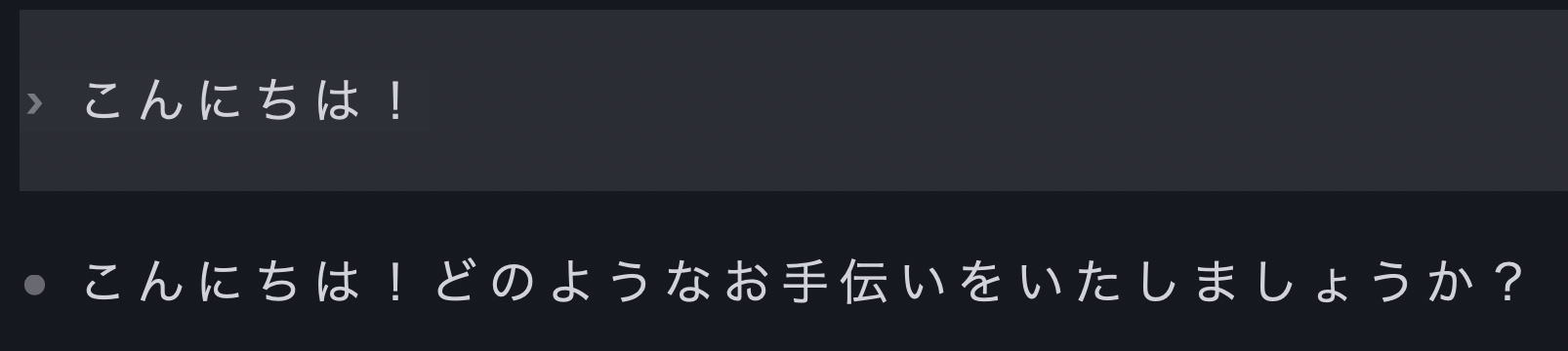

実際にCodexにメッセージを送信すると、適切に返答が返っていることが分かります。

LM Studio の Developer Logs にも、以下のようにリクエストが来ていることが確認できます。

まとめ

LM StudioとCodex CLIを組み合わせると、ローカルLLMを「Codex CLIの実行エンジン」として使えるようになり、ネットワーク要件や運用ポリシーの都合でクラウド型のコーディングエージェントが使いにくいケースでも、試せる選択肢が増えます。

またセキュリティ観点のみにとどまらず、Codexの利用制限の対策として使える点も、ローカルLLMの魅力のひとつです。

株式会社Digeon では法人向けAIエージェントのファーストステップに最適なサービスである「ENSOU AI」を提供しています。

無料ですぐに使えるフリープランのご利用開始はこちらから👇

サービス紹介資料をこちらからダウンロードいただけます👇

ご相談、無料トライアルは、以下からお問い合わせください👇

.png)