2025年8月12日

Ollama vs LM Studio ローカルLLMツールの特徴・使いやすさ・選び方ガイド

ローカルLLMを試すならOllamaとLM Studioのどちらが最適?特徴・対応モデル・インストール手順・使いやすさを徹底比較し、利用目的別におすすめを紹介します。

先日のOpenAI社によるGPT-OSSの発表により、ローカルLLMに関する注目が非常に高まっています。

本記事ではローカルLLMを実行するアプリケーションである、 Ollama と LM Studio を紹介・比較し、ローカルLLMを試す際にどんなツールを使用すれば良いのかについて解説します。

ローカルLLMやGPT-OSSを利用し、社内でセキュリティ安全な生成AI活用に興味のある方は、ぜひご覧ください。

弊社では、法人向けにセキュアな生成AI活用ができるENSOUチャットボットというサービスを提供しています。 サービス紹介資料 はこちらからダウンロードできます。また自社クラウドやオンプレミス環境で生成AI活用ができる ローカルLLM構築サービス を提供しています。

ENSOUチャットボットでは、クレジットカード登録・申込不要でフリープランがご利用可能です。

フリープランでもすべての機能が使えるようになっているので、ぜひENSOUチャットボットをお試しください。

無料ですぐに使えるフリープランのご利用開始はこちらから👇

OllamaとLM Studioとは?ローカルLLMツールの概要

Ollamaの特徴と基本機能

Ollama は、 Mac / Windows / Linux で大規模言語モデル(LLM)をローカル実行できるオープンソースツールです。

GPT-OSS、DeepSeek R1、Google Gemma 3、Alibaba Qwen3 などの人気モデルを、APIや画面経由で手軽に利用できることが特徴です。

また他のツールに対する強みとしては、LLMフレームワークである LlamaIndex や LangChain などとの相性が良く、これらのツールで Ollama とインテグレーションするための独自の機能が提供されていることが挙げられます。

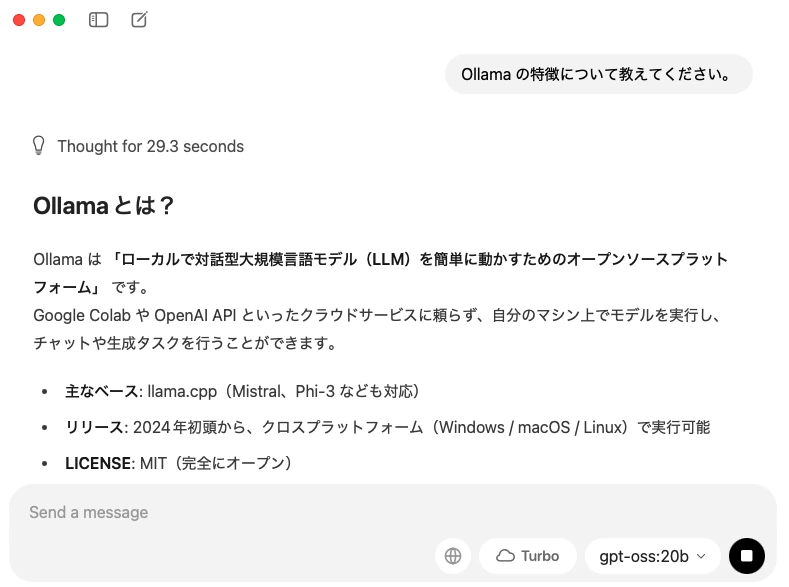

Ollama は当初からCLIツールとして、画面操作を経由せずにコマンド経由で動かすツールとして提供されてきましたが、2025年7月30日にGUIアプリケーションの提供が公式ブログでアナウンスされました。

これによって開発者がローカルLLMを試すためのツールから、開発者以外でも一定使いやすいツールへと進化しました。

LM Studioの特徴と基本機能

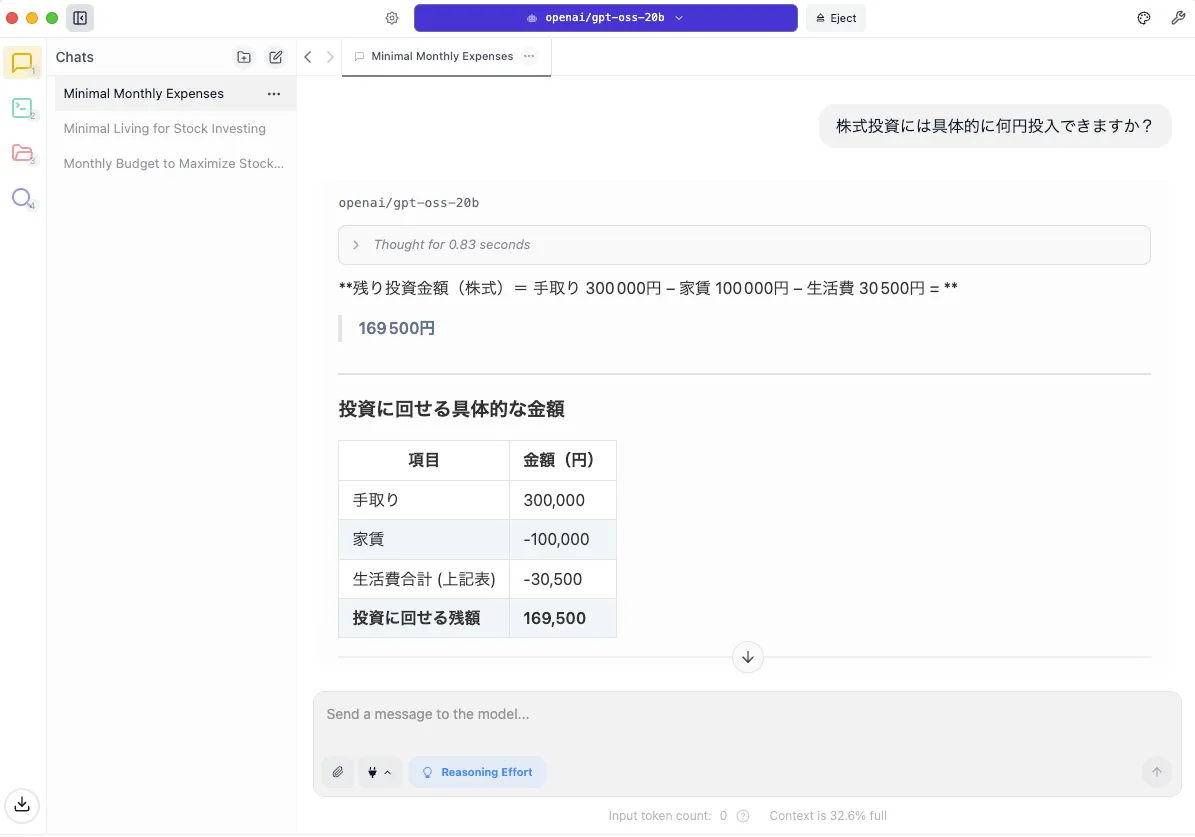

LM Studio は、Mac / Windows / LInux のデスクトップ上で大規模言語モデルをローカル実行できるGUIアプリケーションです。

Ollama がオープンソースでGitHub上でソースコードが確認できるのと比較して、 LM Studio は周辺ツールがオープンソース化されているものの、アプリケーションの本体はOSSとして提供されているわけではありません。

Ollamaと異なり、当社からGUIアプリケーションとして構築されてきた経緯があり、GUI経由でリッチな操作が可能となっている特徴があります。

リッチな操作の例として、対象ユーザーを一般・パワーユーザー・開発者の3つに分類しており、それぞれに合わせた表示項目の変更が可能となっています。例えば、一般ユーザー向けには Ollama の現時点のUIに近いような、なるべくシンプルなUIの提供がなされています。

インストールとセットアップのしやすさを比較

対応OS

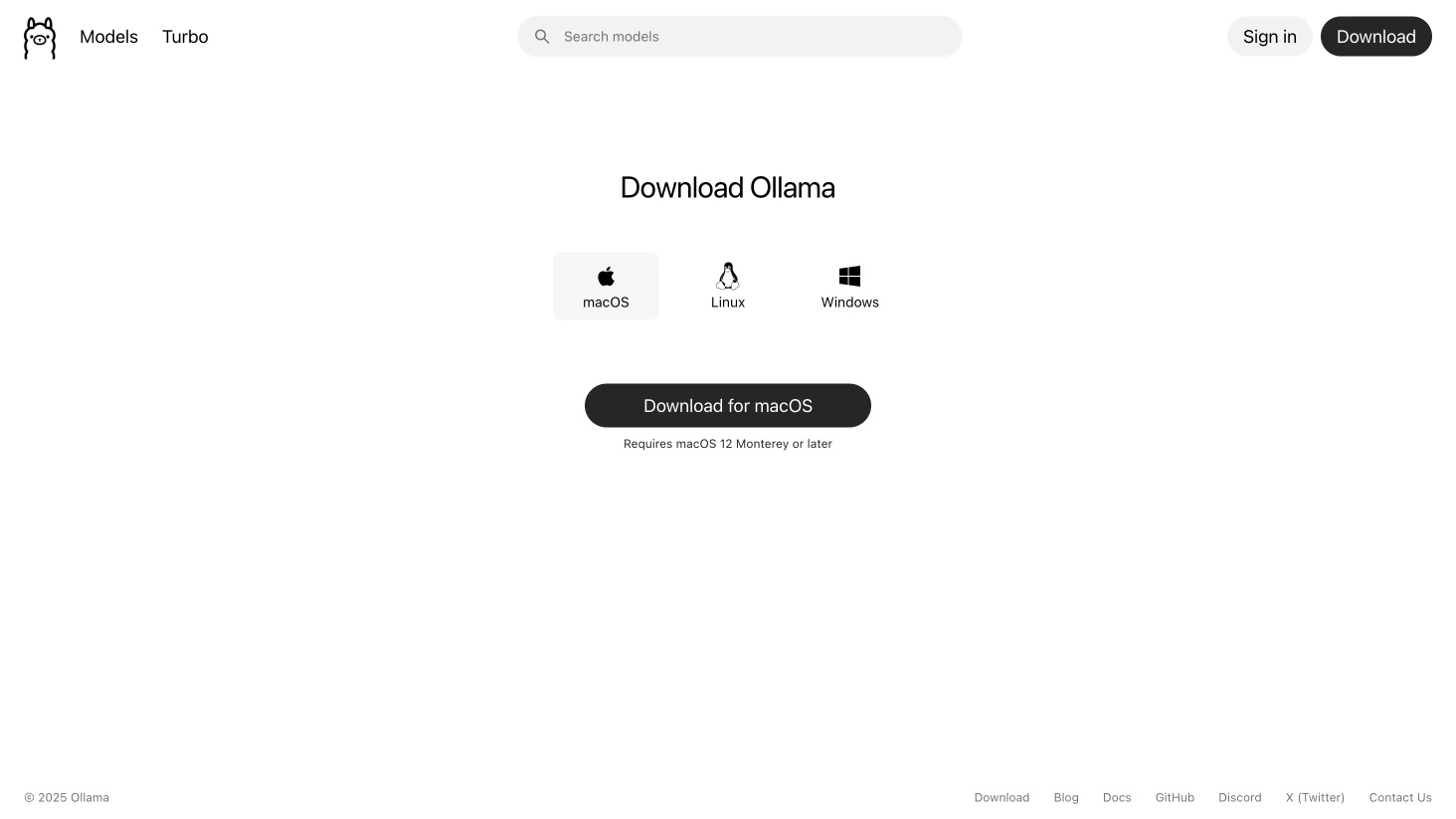

Ollama と LM Studio のどちらのツールも、 Mac / Windows / Linux の3つのOSに対応しています。

初期設定の手順と所要時間

Ollama は 公式サイトのダウンロードページ からアプリを取得し、起動後にGUIからモデルを選択してメッセージを送信するだけで、モデルのダウンロードから推論の実行までを実現できます。また、CLI経由でモデルを取得して推論を動かすことも簡単なコマンド操作のみで実現できます。

LM Studio も同様に 公式サイト からアプリを取得します。こちらは手順がもう少し丁寧で、モデルの選択・モデルのダウンロード・推論の実行に、それぞれ適したユーザーインターフェースが提供されており、ステップバイステップで分かりやすく実行できるのが特徴です。

ただどちらも設定に手間取ったり、時間を要したりすることなく、直感的に手軽に利用できるツールです。

対応モデルの違い

Ollama で使えるモデル

Ollama の 公式対応モデルページ から利用できるモデルの一覧が確認できます。

上記の一覧で主要なモデルについてかなり網羅しているのに加え、HuggingFaceからモデルをダウンロードして実行することも可能です。詳しくは HuggingFace のドキュメント に記載されています。

LM Studio で使えるモデル

LM Studio は HuggingFace からモデルをダウンロードして実行するのがメインの機能であり、利用できるモデルについては Ollama とほとんど差異はありません。

どちらを選ぶべきか?利用目的別のおすすめ

開発者向けの選び方

開発者やエンジニアとしてローカルLLMを活用する場合は、Ollamaがより適した選択肢になるケースが多いです。

OllamaはCLIベースでの操作やREST APIの提供が充実しており、アプリケーションやサービスへの組み込みが容易です。例えば、ローカルWebアプリからOllamaのエンドポイントを呼び出し、生成結果を直接取得することが可能です。

また、OllamaはLlamaIndexやLangChainなどの各種LLMフレームワークがそれに特化したインテグレーション機能を提供していることもあり、Ollama 用のコードを簡単に書けます。また OpenAI の互換APIを提供しているため、OpenAI SDK をそのまま使い回すことも、どちらの選択もできる点は強みです。

LM Studio も lms コマンド機能を提供しているので好みの問題とも言えるかも知れませんが、当初からターゲットをエンジニアに絞っている Ollama に一日の長があると言えます。

非エンジニアや個人利用の場合の選び方

プログラミング経験が少ない、あるいはまったくない場合は、LM Studioが圧倒的に使いやすいです。理由は、インストールから利用までをGUIで完結できる点にあります。

LM Studio は初回起動時に自身が開発者かそれとも一般ユーザーであるかを選択すると、それに合わせて最適なUIに変更してくれます。(あとからこの設定は変更可能です。)

また、検索バーからモデルを探し、「ダウンロード」ボタンを押すだけで利用可能になります。設定もスライダーやチェックボックスで直感的に行えるため、パラメータ調整やモデル切り替えも容易です。

また、チャットインターフェースを中心にGUIは Ollama よりも丁寧に作り込まれています。ChatGPTに近い感覚で使えるため、AI初心者でも違和感なく操作できます。

そのため、プログラミングなしで快適にローカルLLMを試したい個人ユーザーや研究者はLM Studioを選ぶのが推奨であると言えます。

まとめ

Ollama はCLIやAPI連携を前提とした開発者志向の設計で、軽量かつ高速な動作が魅力です。一方、LM Studio はGUI中心で直感的な操作性を持ち、非エンジニアや個人ユーザーでもすぐにローカルLLMを活用できる利便性があります。

両者に共通して言えるのは、インターネットに依存せず、プライバシーやセキュリティを確保しながら生成AIを利用できる点です。

これは、GPT-OSSをはじめとする高性能なオープンLLMの登場により、企業・個人問わず需要が急増している分野です。特に社内ドキュメントや顧客データを扱う場合、クラウド依存型の生成AIに比べて大幅にリスクを低減できます。

株式会社Digeonでは、法人向けに ChatGPT をセキュアに使えるサービスである「ENSOUチャットボット」を提供しています。サービス紹介資料をこちらからダウンロードいただけます👇

また、ローカルLLMを自社のクラウドやオンプレミス環境に構築する ローカルLLM構築サービス を提供しています。もしご興味をお持ちいただける場合は、ぜひともお問い合わせください。