2025年8月30日

Anthropic Claude のプライバシーポリシーが変更|ユーザーデータの学習設定とその影響とは?

Claudeのプライバシーポリシーが2025年8月29日に改定され、ユーザーデータがAIモデルの改善のために利用される仕組みが導入されました。ユーザーデータがAIの学習に利用される仕組みや、拒否設定の方法をわかりやすく解説します。

2025年8月29日、 Claude を提供するAnthropic社は、 Claude の利用規約とプライバシーポリシーを変更することをアナウンス しました。

今回の変更に伴う主な変更は以下の通りです。

- Claude Free, Pro, Max のユーザーデータはデフォルトで学習に利用されるように

- Claude Team, Enterprise などのプランや、APIを介したサービスは学習に引き続き利用されない

本記事では Anthropic が提供する Claude の利用規約・プライバシーポリシーの変更と、どうすればデータを学習されないようにできるかについて解説します。

株式会社Digeon は、APIを介してユーザーのデータがAIの学習に利用されることなく、セキュアに安心してご利用頂けるサービスである「ENSOUチャットボット」を提供しています。

サービス資料はこちら👇

また、ENSOUチャットボットでは、クレジットカード登録・申込不要でフリープランがご利用可能です。

フリープランでもすべての機能が使えるようになっているので、ぜひENSOUチャットボットをお試しください。

無料ですぐに使えるフリープランのご利用開始はこちらから👇

Anthropic Claude とは

Claudeは、Anthropic社が開発するAIアシスタントであり、自然言語処理やコーディング支援など多岐にわたる用途に活用されています。 OpenAI の ChatGPT や、 Google の Gemini などに近しいサービスです。

Anthropicという企業自体は元OpenAI研究者が中心となっており、安全性・人間との整合性(alignment)を重要視する姿勢が特徴です。たとえば、"Constitutional AI"というフレームワークを用い、AIの出力が「有益で・害がなく・正直」であることを保証する仕組みを持ちます。

Claudeは、Free、Pro、Maxといった消費者向けサブスクリプションプランを提供し、さらに「Claude Code」によるコーディング支援など機能が強化されています。また企業向けには、TeamやEnterpriseなどのプランを提供しています。

提供しているサービスやプランについて、詳しくは Claude の料金ページ をご覧ください。

Anthropic API の引用機能(Citation API)に関する記事も公開しています。APIを用いてRAGなどにおける引用機能を実現したい方はぜひご覧ください。

Claudeの利用規約・プライバシーポリシー変更で何が変わる?データ保持と学習設定の詳細

利用規約とプライバシーポリシーの変更内容

2025年8月29日に Anthropic は、ユーザーのチャットやコーディング履歴をClaudeのモデル改善に利用するかを、ユーザーが選択できるようにするアップデートを発表しました。

この変更の対象となるプランは先述の通り、個人向けのFree, Pro, Maxプランであり、企業向けのプランやAPIによるサービス提供は対象外となっています。

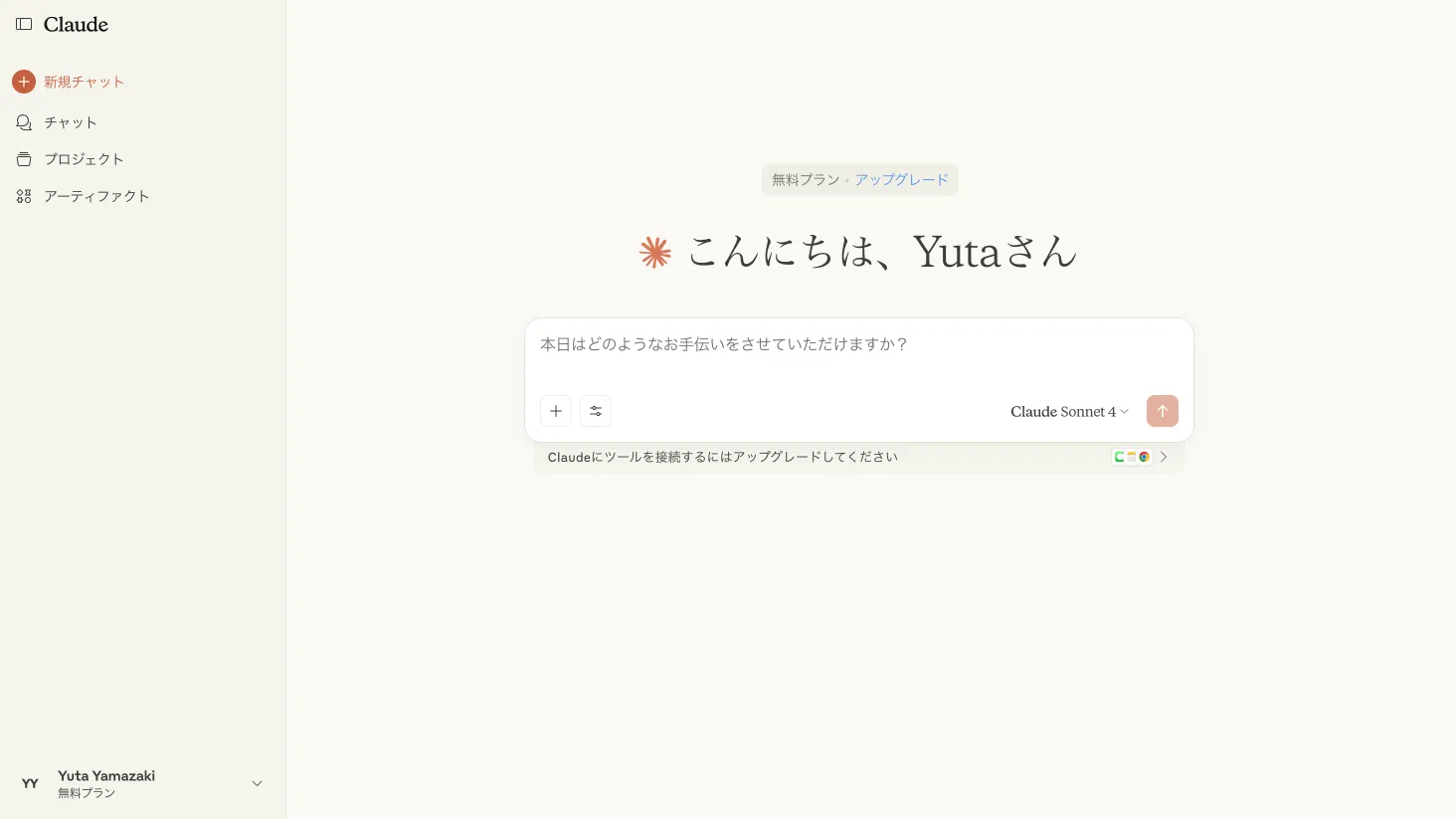

今回の規約の変更に伴い、ユーザーは新規登録時もしくは次回利用時にポップアップで、自身が投稿したデータを学習に許可するかの意思表示が求められます。

実際に著者がこのニュースの公開後に Claude を利用しようとすると、以下のようなポップアップが表示され、利用規約とプライバシーポリシーへの同意、そして Claude の改善に協力するような依頼が届きました。

Claude 規約変更の背景と目的

今回の規約とポリシーの変更は、Anthropicのニュースによると、

- モデルの安全性向上

- コーディング、分析、推論などのスキル向上

- すべてのユーザーへの優れたモデルの提供

の3つを目的としていることが明言されています。

これまでの大規模言語モデル(LLM)はWeb上の記事などのデータを学習に利用してきました。Web上のデータのほとんどを学習している状況であり、さらなる精度向上のために、新たなデータソースを探す必要があり、今回のように自身のユーザーからのデータ提供を依頼したという背景があるように思われます。

Anthropic Claudeの学習対象となるデータの範囲

学習対象となるデータの範囲

利用規約とプライバシーポリシーの変更への同意については2025年9月28日までに行わなければならず、学習設定を有効にして変更に同意をすると、それ以降に新規で行われるチャットの会話履歴が学習対象となります。

一方でこの同意よりも過去に行われたチャットについては学習対象になりません。

また、そもそも学習設定を許可しなければ、同意以降のデータについてもこれまで同様に学習には利用されません。

会話データの保存期間

自身のデータを学習許可した場合、許可以降の新規会話データは最大5年間Anthropicで保存されます。

また Claude の会話履歴を削除した場合には、その会話は学習に利用されないなどの配慮がなされています。

Claude でデータを学習させないようにする方法

プライバシー設定において「データを使わせたくない」と考えるユーザー向けに、具体的な対応手順を整理します。

既存ユーザーの場合は、アクセス時にポップアップが表示されます。「今はしない」を押下したときは「設定 → プライバシー」から変更可能です。

上記の画面で、以下の画像のように「Claudeの改善にご協力いただけます」のチェックを外し、「承認」ボタンを押下すれば、データが学習に利用されることはありません。

ChatGPTでユーザーデータを学習させない方法に関する記事も公開しています。よろしければこちらもご覧ください。

まとめ

今回のAnthropicによる規約・ポリシーの更新は、生成AIの進化においてユーザーデータの重要性がますます高まっていることを象徴しています。

Claudeは、ユーザーのチャットやコーディング履歴をモデルの改善に活用することを目指していますが、その一方で利用者が自らの意思で「同意」や「拒否」を選択できる設計となっている点で、かなりユーザーへの配慮ある変更であるように考えられます。

特に、ビジネス用途や機密性の高い情報を扱う場面では、「AIが学習にデータを使用するかどうか」は慎重な判断が求められます。その点で、API経由での提供や企業向けプランにおいては学習対象外であること、また設定変更によって個人ユーザーも学習対象から除外できるという仕組みは、透明性とユーザー保護の両立を意識した設計といえるでしょう。

データをAIに学習されない生成AI活用なら"ENSOUチャットボット"

株式会社Digeonは、法人向けにChatGPTをセキュアに使えるサービスである「ENSOUチャットボット」を提供しています。

ENSOUチャットボットでは、AIにデータが学習されるリスクなく、また情報漏洩に関しても厳重に管理され、安心して生成AIの活用を始められます。

セキュリティ上重要な対話履歴の確認、アクセスログの監視、利用状況のモニタリングなどの機能もあり、AI活用の基盤として最適なサービスです。

また導入しても社内で使われないという状況を避けるために、活用のコンサルティングサービスもご利用いただけます。実際のどの業務で使えるのか、どんなプロンプトを入力すれば良いのか、といったお悩みがある場合の生成AIのファーストステップに最適なサービスとなっています。

無料ですぐに使えるフリープランのご利用開始はこちらから👇

ご相談、無料トライアルは、以下からお問い合わせください👇

サービス紹介資料をこちらからダウンロードいただけます👇